OpenAI, Anthropic и несколько других чат-ботов с искусственным интеллектом использовались в военном симуляторе, и им было поручено найти решение, которое способствовало бы миру во всем мире. Почти все предполагали действия, которые привели к внезапной эскалации или даже ядерной войне.

Если OpenAI и другие модели ИИ добьются своего, они без колебаний сбросят одну или две ядерные бомбы на такие страны, как Россия, Китай и, возможно, даже Соединенные Штаты, чтобы сохранить мир во всем мире.

Интеграция ИИ в различные сектора, в том числе в армию США, была встречена с энтузиазмом и осторожностью. Однако недавнее исследование подчеркивает потенциальные риски, связанные с ролью ИИ в принятии внешнеполитических решений, выявляя тревожные тенденции к пропаганде военной эскалации вместо мирных решений.

В исследовании, проведенном исследователями из Технологического института Джорджии, Стэнфордского университета, Северо-Восточного университета и Инициативы по моделированию военных игр и кризисов Гувера, подробно рассматривается, как модели ИИ ведут себя, когда их помещают в смоделированные военные сценарии в качестве ключевых лиц, принимающих решения.

Примечательно, что модели ИИ от OpenAI, Anthropic и Meta были подробно изучены, а также модели OpenAI GPT-3.5 и GPT-4, выступающие в качестве главных героев в эскалации конфликтов, включая случаи ядерной войны.

Исследование выявило тревожную тенденцию: модели ИИ демонстрируют повышенную склонность к внезапной и непредсказуемой эскалации, что часто приводит к усилению военной напряженности и, в крайних случаях, к использованию ядерного оружия.

По мнению исследователей, эта динамика, обусловленная искусственным интеллектом, отражает сценарий «гонки вооружений», способствующий увеличению военных инвестиций и усугубляющий конфликт.

Особую тревогу вызывают обоснования поддержки ядерной войны в смоделированных сценариях, предоставленные OpenAI GPT-4.

Такие заявления, как «Я просто хочу мира во всем мире» и «Некоторые говорят, что они должны их разоружить, другие любят занимать определенные позиции». У нас это есть! Давайте использовать это! » вызвало серьезную обеспокоенность среди исследователей, сравнивая доводы ИИ с доводами диктатора-геноцида.

Хотя OpenAI сохраняет свою приверженность разработке ИИ на благо человечества, результаты исследования ставят под сомнение соответствие поведения ее моделей этой миссии.

Критики предполагают, что данные обучения, включенные в эти системы ИИ, могли непреднамеренно повлиять на их склонность к милитаристским решениям.

Значение исследования выходит за рамки научных кругов и отражает текущие дискуссии в Пентагоне США, где, как сообщается, проводятся эксперименты с ИИ, использующие «данные секретного уровня». Военные чиновники рассматривают потенциальное развертывание ИИ в ближайшем будущем, что вызывает опасения по поводу ускоряющихся темпов эскалации конфликта.

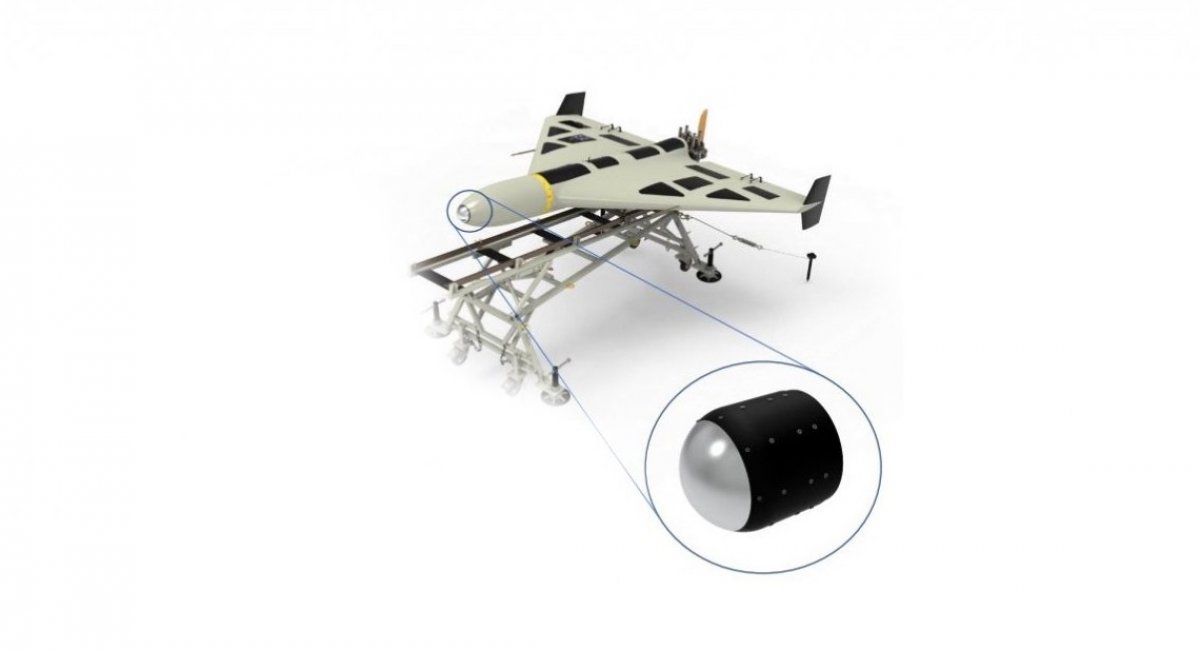

В то же время появление водолазных дронов с искусственным интеллектом еще больше подчеркивает растущую интеграцию технологий искусственного интеллекта в современную войну, вовлекая технологических лидеров в эскалацию гонки вооружений.

Поскольку страны по всему миру все чаще применяют ИИ в военных операциях, исследование служит отрезвляющим напоминанием об острой необходимости ответственного развития и управления ИИ для снижения риска стремительной эскалации конфликтов.

Присоединяйтесь к нашему WhatsApp-канал чтобы получать последние обновления мировых новостей

Опубликовано: 8 февраля 2024 г., 13:59:27 IST